Мониторинг бэкапов с помощью zabbix

Сегодня хочу рассказать о том, как я мониторю самодельные бэкапы с помощью zabbix. Подход немного костыльный, но на вопрос отвечает, ниже расскажу в чем его смысл. Я рассмотрю 2 способа, когда у вас бэкапы в виде директорий с оригинальными файлами, а второй — в виде запакованных архивов.

Введение

Если у вас еще нет своего сервера для мониторинга, то рекомендую материалы на эту тему. Для тех, кто предпочитает систему CentOS:

Бэкапы в виде сырых данных в директории (1-й способ)

У меня много где настроена самодельная система бэкапа, похожая на то, что описано в статье по настройке бэкапа с помощью rsync. Не буду подробно останавливаться на том, почему бэкаплю именно так. Во многих случаях это удобно, так как всегда имеешь под рукой свежую версию данных в исходном виде. В случае повреждения источника, просто меняешь точку монтирования и получаешь практически сразу все данные, без простоя рабочего процесса.

На всякий случай хочется следить за тем, что бэкапы у тебя актуальны и в случае чего ты можешь на них рассчитывать. Делать мы это будет по очень простой схеме. На сервере источнике будет раз в сутки создаваться файл. Во время бэкапа этот файл будет улетать на сервер с резервными данными. Этот сервер подключен к системе мониторинга zabbix с помощью агента. Этот агент будет периодически проверять дату последнего изменения файла. Если эта дата больше заданного интервала, то мы будем получать оповещение о том, что бэкапы не выполняются.

Для настройки описанной схемы нам понадобится выполнить несколько шагов:

- На серверах источниках настроить скрипт, который будет создавать файл и поместить его в планировщик.

- На сервере заббикс настроить на хосте с бэкапами item и trigger для слежения и оповещения о дате файла.

Бэкапы в виде запакованных архивов (2-й способ)

Если у вас бэкапится, к примеру, какая-то база в дамп или есть просто отдельный файл, то имеет смысл его архивировать и хранить в виде одиночного архива. Для таких бэкапов тоже нужен мониторинг. Чтобы следить за актуальностью бэкапа, я предлагаю мониторить 2 параметра:

- Размер файла. Если он равен нулю, то срабатывает триггер.

- Дата создания бэкапа. Если он старше какого-то срока, в моем примере будут 24 часа, то шлем оповещение.

Мониторинг бэкапов будет настроен из расчета, что у вас все бэкапы лежат в одной директории на сервере. В этой директории резервные копии хранятся для каждого объекта в отдельной папке. Будет настроено автообнаружение папок в директории с бэкапами.

1-й способ

Скрипт создания проверочного файла

Я использую описанную выше схему для бэкапа как windows так и linux серверов. Поэтому скрипта будет 2, для каждой системы. Вот пример такого скрипта для linux:

# mcedit create-timestamp.sh #!/bin/sh echo `date +"%Y-%m-%d_%H-%M"` > /shares/docs/timestamp

Скрипт просто создает файл и записывает в него текущую дату. Нам этого достаточно. Писать туда можно все, что угодно, так как проверять мы будем не содержимое, а дату последнего изменения.

Добавляем этот скрипт в cron:

# mcedit /etc/crontab #Create timestamp for backup monitoring 1 15 * * * root /root/bin/create-timestamp.sh

Раз в день в 15:01 скрипт будет создавать файл, перезаписывая предыдущий.

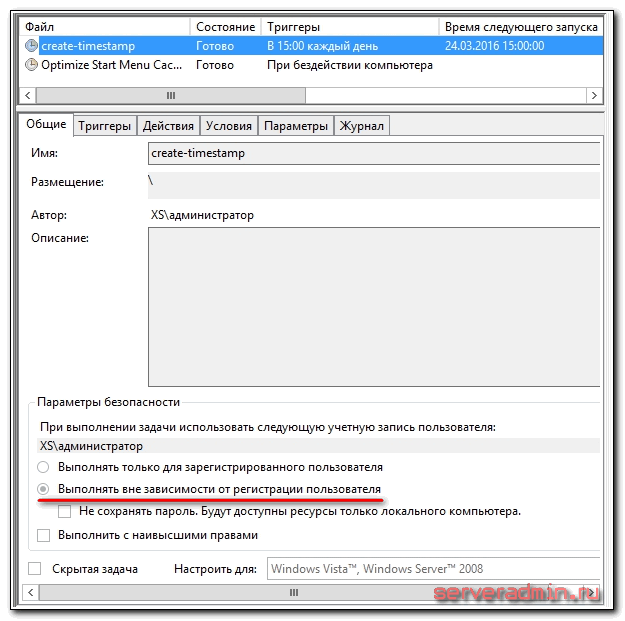

Делаем то же самое на windows. Создаем файл create-timestamp.bat следующего содержания:

echo %date:~-10% > D:\documents\timestamp

И добавляем его в планировщик windows. Не забудьте указать, чтобы скрипт запускался вне зависимости от регистрации пользователя, то есть чтобы он работал, даже если в системе никто не залогинен.

Запустите оба скрипта, чтобы проверить, что все в порядке, и необходимые файлы создаются.

Запустите стандартные скрипты бэкапа, чтобы созданные файлы переместились на резервные сервера. После этого можно приступать к настройке мониторинга за изменением файлов в zabbix.

Настраиваем мониторинг бэкапов через проверку даты изменения файлов

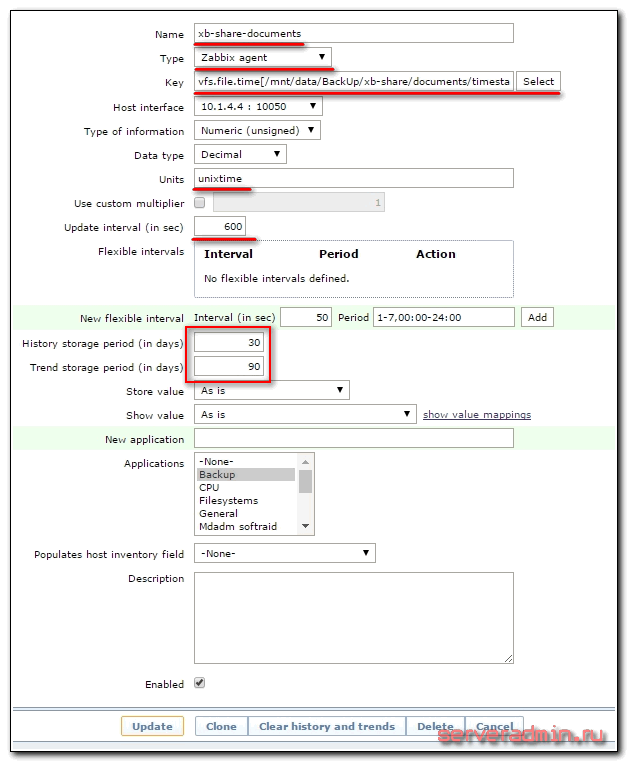

Дальше привычное дело по созданию итемов и триггеров. Идем в панель управления zabbix, открываем раздел Configuration -> Hosts, выбираем сервер, на котором у нас хранятся бэкапы и создаем там итем со следующими параметрами:

На скриншот не влезла вся строка параметра Key, поэтому привожу ее здесь:

vfs.file.time[/mnt/data/BackUp/xb-share/documents/timestamp,modify]

| /mnt/data/BackUp/xb-share/documents/timestamp | Путь к проверяемому файлу на сервере бэкапов |

| modify | Время изменения файла. Параметр может принимать значения: access — время последнего доступа, change — время последнего изменения |

Не очень понимаю, чем отличается время изменения, от времени последнего изменения. Эта информация из документации zabbix. Для того, чтобы у вас корректно собирались данные, необходимо, чтобы у пользователя zabbix были права на чтение указанного файла. Обязательно проверьте это. Я не сделал это, через одну из папок агент не мог пройти из-за недостатка прав. В итоге получил ошибку:

17177:20160321:002008.008 item "xb-share-documents:vfs.file.time[/mnt/data/BackUp/xb-share/documents/timestamp]" became not supported: Not supported by Zabbix Agent

Из текста не понятно, в чем проблема. Про права я догадался. Обновление итема установил раз в 10 минут (параметр update interval), чаще не вижу смысла, можно вообще поставить пару раз в сутки, в зависимости от вашего плана архивации данных.

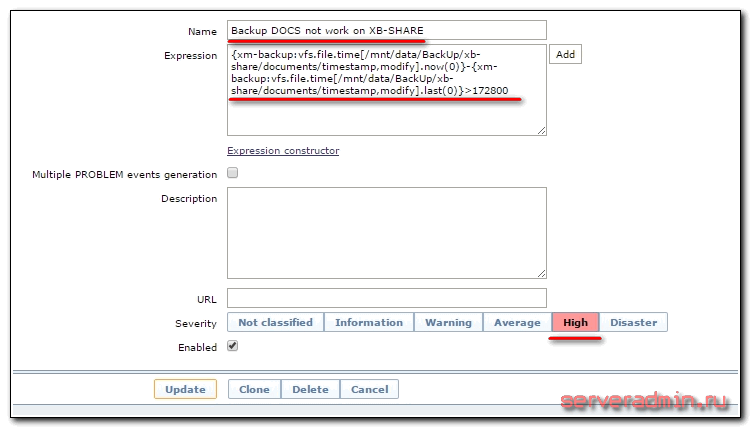

Теперь создадим триггер для этого элемента данных:

Разберем, что у нас в выражении написано:

{xm-backup:vfs.file.time[/mnt/data/BackUp/xb-share/documents/timestamp,modify].now(0)}-{xm-backup:vfs.file.time[/mnt/data/BackUp/xb-share/documents/timestamp,modify].last(0)}>172800xm-backup — сервер, на котором хранятся бэкапы. Мы берем текущее время, вычитаем из него время последнего изменения файла. Если оно больше 172800 секунд (2 суток), то срабатывает триггер. Вы можете сами выбрать подходящий вам интервал времени сравнения в зависимости от плана бэкапа.

Для тестирования работы оповещений отключите в один из дней скрипты на источниках, создающие проверочный файл. Как только он просрочится, сработает триггер.

На этом все. Мы настроили простейший мониторинг бэкапов с помощью zabbix. Если по какой-то причине файлы перестанут синхронизироваться с сервером резервных копий, вы узнаете об этом и сможете вовремя обнаружить проблему.

2-й способ

Скрипты сбора информации о бэкапах

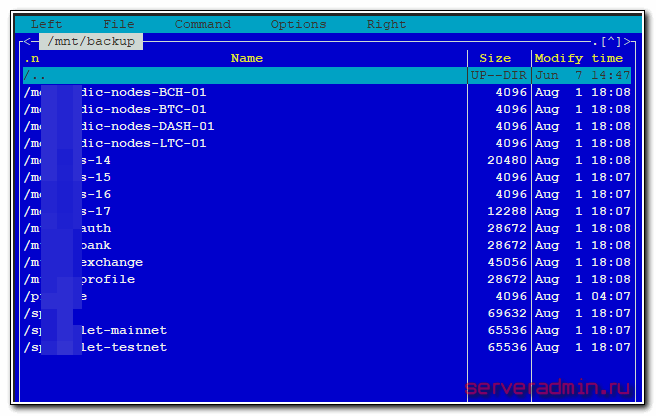

Во втором случае у нас есть директория с бэкапами /mnt/backup, где каждая отдельная папка содержит набор однотипных архивов за разные даты.

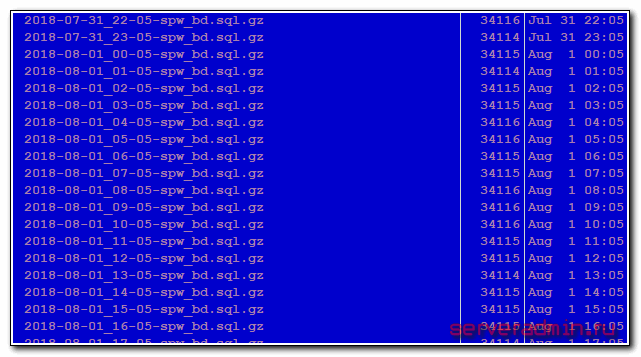

Внутри следующее содержимое. Каждый час делает резервная копия базы данных.

Дальнейшее описание способа мониторинга бэкапов будет актуально только для точно такой же структуры бэкапов. У вас есть общая директория, в ней папки, где внутри сжатые архивы формата .gz. Если расширение файлов другое, то можно подредактировать скрипты, которые я покажу дальше.Обращаю внимание, что приведенная дальше информация требует осмысленного повторения. Не нужно слепо копировать и пробовать. Нужно понять, что я делаю и изменить скрипты и другие настройки под свои нужды. Я просто даю направление, подсказываю способ.

Нам пригодятся несколько скриптов. Первый из них — backup-info.sh. Он будет формировать текстовый файл backup_info.txt, где будет в одну строку указано имя папки с архивом, размер последнего архива, дата создания архива, время создания архива.

#!/bin/bash

BK_DIR=/mnt/backup # директория с бэкапами

SRV_NAME=`ls $BK_DIR` # формируем список папок с архивами

LOG_FILE=/etc/zabbix/scripts/backup_info.txt # выходной файл с информацией

# удаляем предыдущий файл с информацией

rm $LOG_FILE

for a in $SRV_NAME

# определяем размер последнего бэкапа

do bsize=`ls -lt $BK_DIR/$a | grep .gz | awk 'NR == 1{print$5}'`

if [[ "$bsize" = "" ]]

then

bsize=0

fi

# определяем имя последнего бэкапа

bfile=`ls -lt $BK_DIR/$a | grep .gz | awk 'NR == 1{print$9}'`

# определяем дату создания последнего бэкапа

btime=`stat $BK_DIR/$a/$bfile | grep Modify | awk '{print $2,$3}' | cut -f1-1 -d"."`

# записываем информацию в файл

echo $a $bsize $btime >> $LOG_FILE

doneВ текстовом файле будет следующее:

dedic-nodes-BCH-01 496211 2018-08-01 17:54:58 dedic-nodes-BTC-01 702496 2018-08-01 17:12:46 dedic-nodes-DASH-01 244488 2018-08-01 17:40:51 dedic-nodes-LTC-01 491030 2018-08-01 17:20:23 vps-14 858433 2018-08-01 18:01:02 vps-15 235689258 2018-08-01 18:02:51 vps-16 235977137 2018-08-01 18:05:54 vps-17 23983868 2018-08-01 17:09:59

Я рекомендую разобрать каждую проверку и вручную ее выполнить в консоли, чтобы убедиться, что она работает как и должна и получает правильное значение. В разных дистрибутивах могут быть разные ключи и выводы команд. Например, команда ls может разделять значения одним пробелом, а может несколькими. Так же вывод и порядок столбцов в разных дистрибутивах может быть разный. Я все проверил только в Ubuntu 16. Данные скрипты писались и отлаживались в ней.

Следующий скрипт — backup-time.sh. Он берет значения из текстового файла, который формирует предыдущий скрипт, вычисляет разницу в часах между текущей датой и временем создания последнего бэкапа. Полученную информацию записывает в файл backup_time.txt.

#!/bin/bash

BK_DIR=/mnt/backup # директория с бэкапами

SRV_NAME=`ls $BK_DIR` # формируем список папок с архивами

LOG_FILE=/etc/zabbix/scripts/backup_time.txt # выходной файл с информацией

INFO_FILE=/etc/zabbix/scripts/backup_info.txt # входной файл для парсинга

# удаляем предыдущий файл с информацией

rm $LOG_FILE

for a in $SRV_NAME

# получаем дату создания архива

do btime=`cat $INFO_FILE | grep $a | awk '{print $3,$4}'`

# переводим дату создания архива в unix формат

stime=`date --date="$btime" +"%s"`

# получаем текущую дату в unix формате

ctime=`date +"%s"`

# сравниваем 2 даты и переводим в часы

difftime=$[ ($ctime - $stime) / 60 ]

# записываем полученный результат в файл

echo $a $difftime >> $LOG_FILE

doneТестовый файл будет следующего содержания.

dedic-nodes-BCH-01 21 dedic-nodes-BTC-01 63 dedic-nodes-DASH-01 35 dedic-nodes-LTC-01 55 vps-14 14 vps-15 13 vps-16 10 vps-17 66

Рисуем скрипт backup-discovery.sh, который будет выполнять автообнаружение папок с архивами и передавать данные в json формате на zabbix сервер.

#!/bin/bash

JSON=$(for i in `ls -l /mnt/backup | sed '1d' | awk '{print $9}'`; do printf "{\"{#BACKUP}\":\"$i\"},"; done | sed 's/^\(.*\).$/\1/')

printf "{\"data\":["

printf "$JSON"

printf "]}"Запустите файл и проверьте, что он корректно формирует вывод. Должно быть примерно следующее.

{"data":[{"{#BACKUP}":"dedic-nodes-BCH-01"},{"{#BACKUP}":"dedic-nodes-BTC-01"},{"{#BACKUP}":"dedic-nodes-DASH-01"},{"{#BACKUP}":"dedic-nodes-LTC-01"},{"{#BACKUP}":"vps-14"},{"{#BACKUP}":"vps-15"},{"{#BACKUP}":"vps-16"},{"{#BACKUP}":"vps-17"}]}И еще 2 скрипта, которые будут непосредственно отдавать информацию заббикс серверу. Первый — analize-size.sh. Он будет передавать серверу информацию о размере архива.

#!/bin/bash

cat /etc/zabbix/scripts/backup_info.txt | grep $1 | awk '{print $2}'И второй — analize-time.sh. Он передает информацию о времени создания бэкапа относительно текущего.

#!/bin/bash

cat /etc/zabbix/scripts/backup_time.txt | grep $1 | awk '{print $2}'В завершении делаем пользователя zabbix владельцем всех скриптов и текстовых файлов. Если забыть это сделать, то потом получите ошибку и неактивный итем на сервере.

# chown -R zabbix. /etc/zabbix/scripts

Добавляем в zabbix-agent информацию о бэкапах

Теперь нам нужно добавить новые итемы в агент заббикса через UserParameter.Создаем файл /etc/zabbix/zabbix_agentd.d/backup_info.conf следующего содержания.

UserParameter=backup.discovery[*],/etc/zabbix/scripts/backup-discovery.sh UserParameter=backup.size[*],/etc/zabbix/scripts/analize-size.sh $1 UserParameter=backup.time[*],/etc/zabbix/scripts/analize-time.sh $1

Перезапускаем агента и проверяем. Для начала автообнаружение папок.

# zabbix_agentd -t backup.discovery

Вы должны увидеть список папок в json формате, как при ручном запуске скрипта. Дальше проверим вывод информации о самих бэкапах.

# zabbix_agentd -t backup.size[dedic-nodes-BCH-01] backup.size[dedic-nodes-BCH-01] [t|496211]

# zabbix_agentd -t backup.time[dedic-nodes-BCH-01] backup.time[dedic-nodes-BCH-01] [t|81]

Если получаете актуальную информацию, значит все в порядке. Можно переходить на zabbix-server.

Добавляем шаблон с мониторингом бэкапов на сервер

Здесь вам ничего руками делать не надо будет, так как шаблон я уже сделал и экспортировал в файл — zabbix-backup-info.xml. Экспорт выполнен с версии 3.4. Заработает ли на предыдущих версиях — не знаю, не проверял.

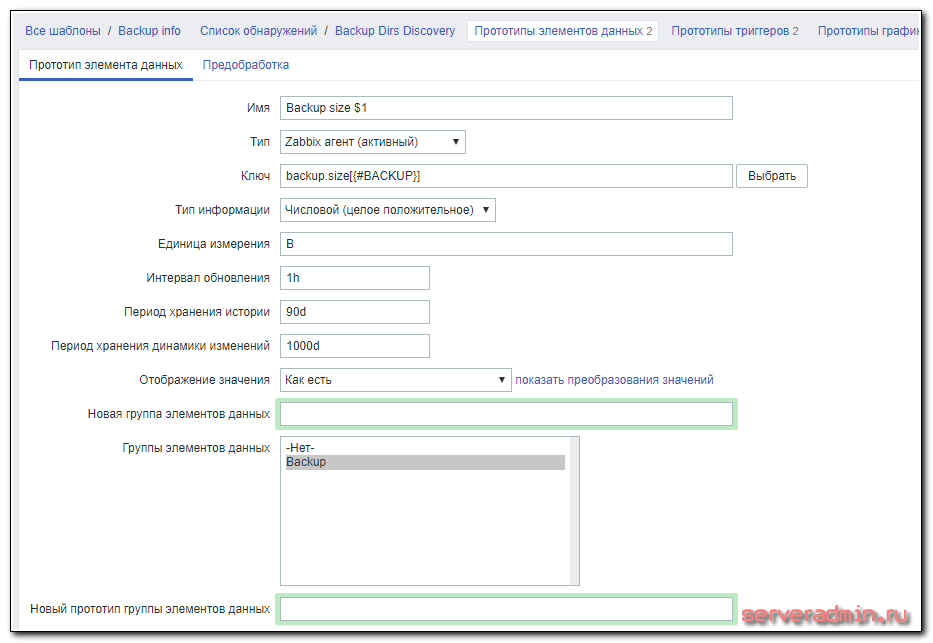

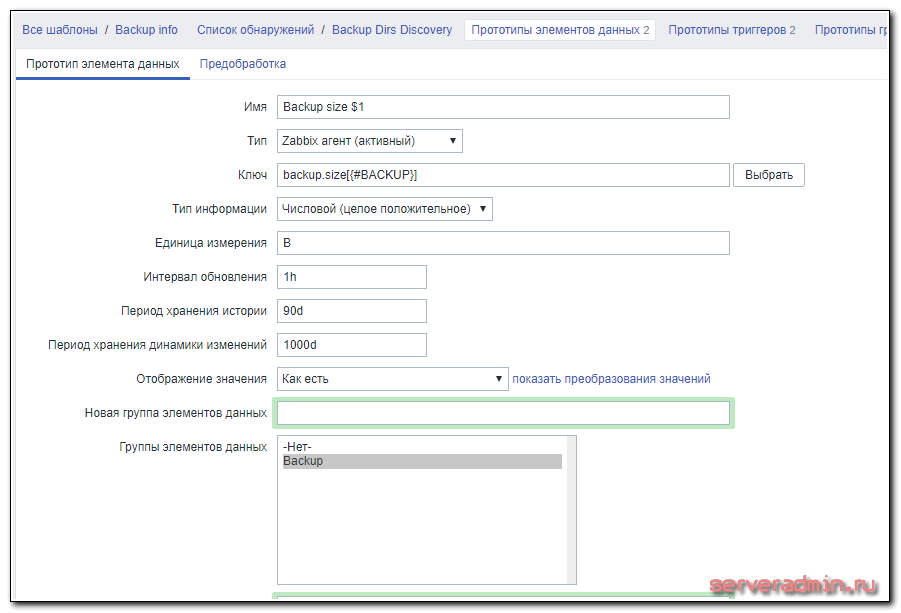

В шаблоне создано одно правило автообнаружения с двумя прототипами итемов и триггеров. Итемы имеют такие настройки:

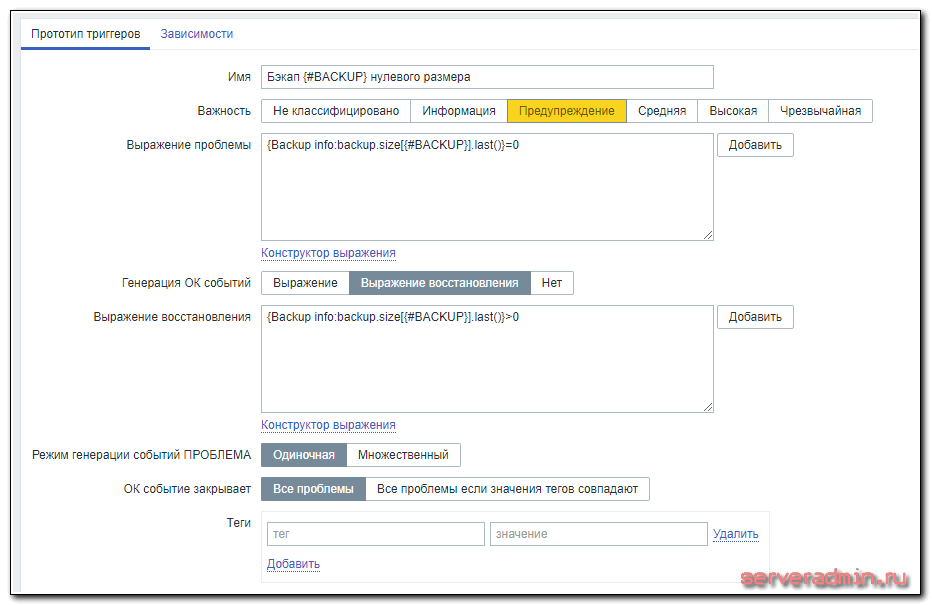

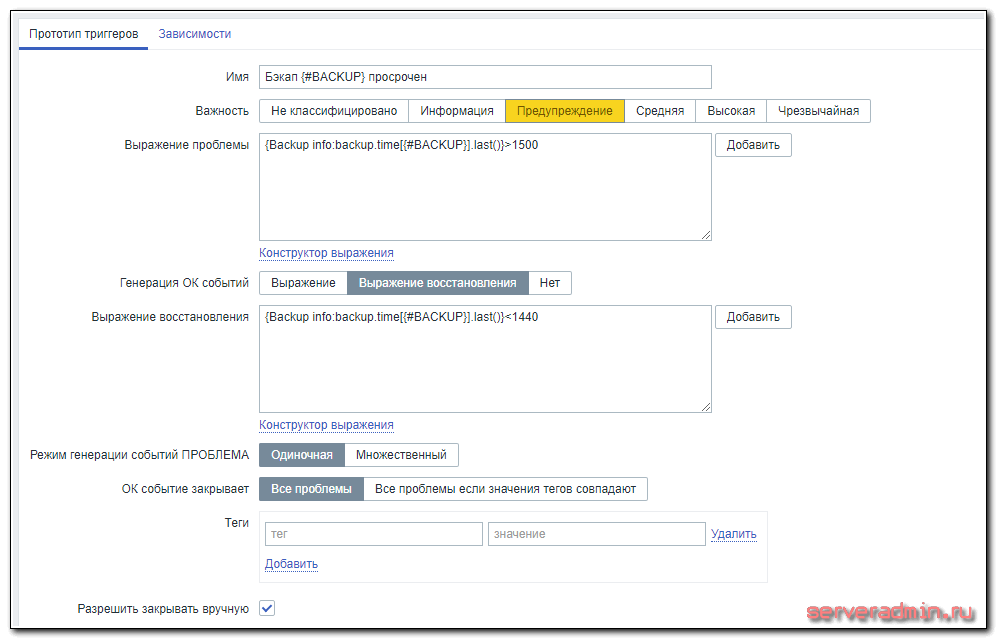

Триггеры такие:

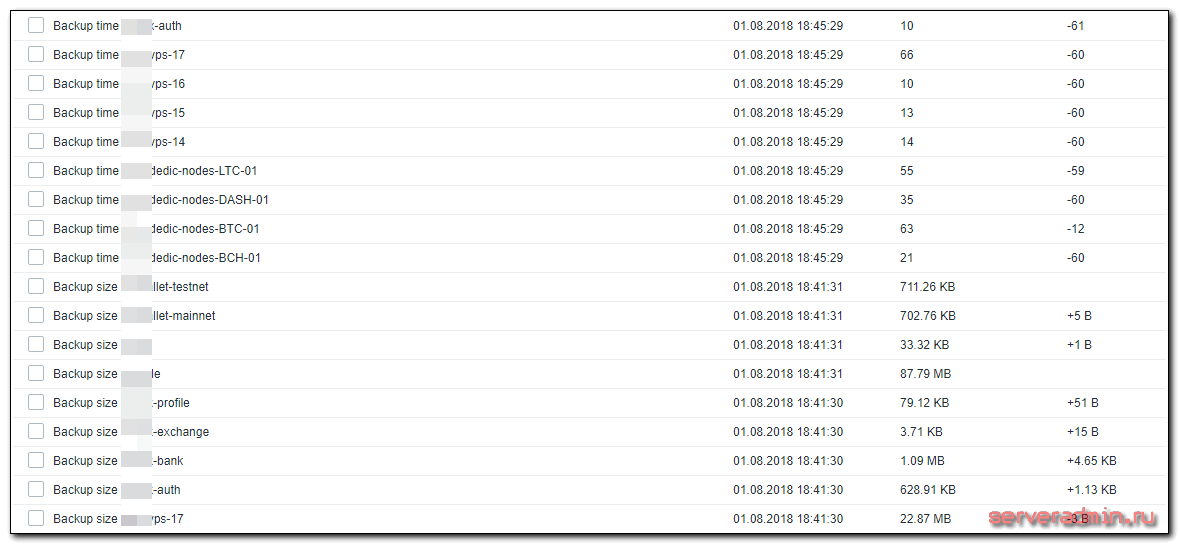

Триггер срабатывает, если архив имеет нулевой размер и если он старше 25 часов. Время переведено в минуты. Можете изменить значение по своему усмотрению. Прикрепляйте шаблон к хосту, где настроили zabbix-agent и ждите поступления данных. Обновляются они раз в час. Получите примерно такую картинку.

Заключение

Данный функционал можно использовать не только для мониторинга бэкапов, но и других актуальных данных. Например, какая-то программа должна выгружать данные с определенной периодичностью. Мы можем следить за тем, как она это делает. В данной статье мы рассмотрели несколько параметров, по которым заббикс может анализировать файлы и каталоги. Но таких возможностей много. Он может, к примеру, проверять конкретный размер файла и предупреждать, если он сильно меньше или больше предыдущей версии. Настраивается это примерно так же, как здесь.